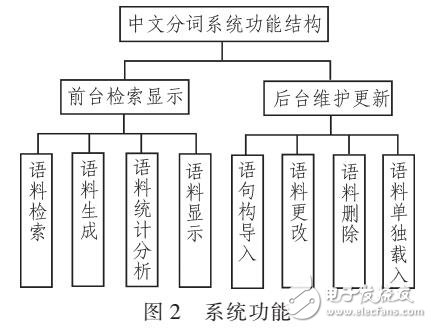

基于SQL Server的中文分词系统设计及应用

基于SQL Server的中文分词系统设计及应用

432x328 - 30KB - JPEG

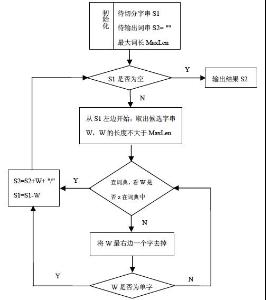

中分分词

中分分词

266x300 - 11KB - JPEG

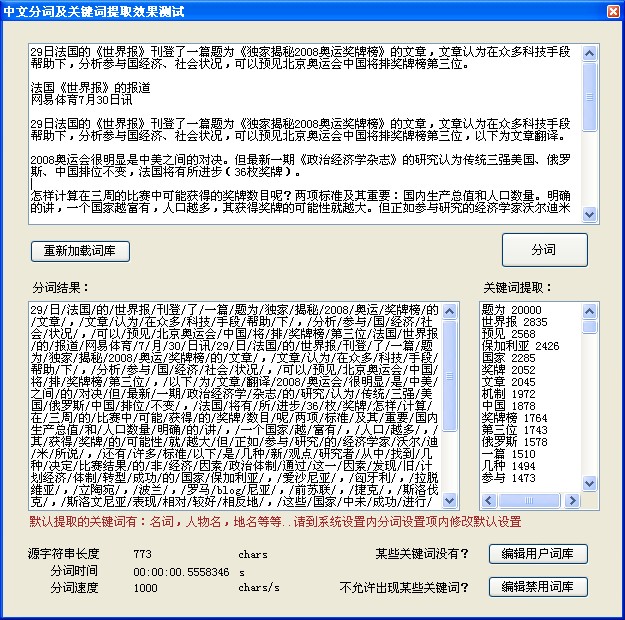

自动中文分词功能,提取关键字

自动中文分词功能,提取关键字

625x620 - 188KB - JPEG

基于Deep Learning的中文分词尝试

865x440 - 34KB - JPEG

中文分词ppt下载

中文分词ppt下载

854x918 - 57KB - JPEG

大数据 语义智能 中文分词

大数据 语义智能 中文分词

400x400 - 39KB - PNG

中文分词器PC版

中文分词器PC版

475x237 - 33KB - JPEG

浅谈中文分词|GameRes游资网

浅谈中文分词|GameRes游资网

1200x900 - 178KB - JPEG

中文分词器PC版

中文分词器PC版

568x253 - 33KB - JPEG

中文分词技术是什么

中文分词技术是什么

640x436 - 33KB - JPEG

中文分词技术最新公开专利信息 北京国双

中文分词技术最新公开专利信息 北京国双

601x898 - 46KB - JPEG

SEO搜索中文分词算法原理分析-SEO综合-

SEO搜索中文分词算法原理分析-SEO综合-

719x255 - 60KB - JPEG

长尾关键词优化与百度中文分词-小小课堂

640x362 - 25KB - JPEG

中文分词工具下载 | 中文分词测试官方版 v

中文分词工具下载 | 中文分词测试官方版 v

936x565 - 79KB - JPEG

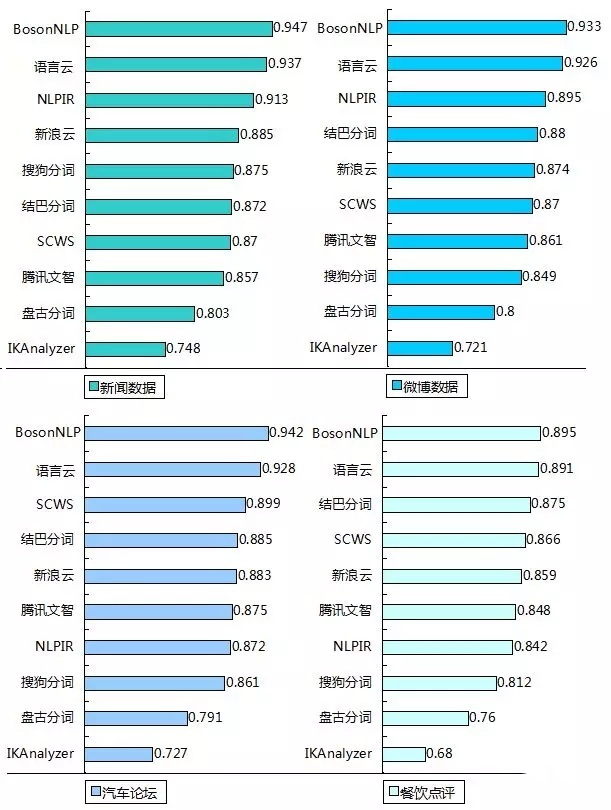

史上最全中文分词工具整理

史上最全中文分词工具整理

611x810 - 302KB - JPEG

简介:中文分词 。分词就是将连续的字序列按照一定的规范重新组合成词序列的过程。我们知道,在英文的行文中,单